360���X�F������Ƴ�ȫ�µ�Light-IFϵ��ģ�ͣ��@һ���¿��ּ���@�����������Z��ģ�ͣ�LLM�����}�sָ����ѭ������������S���˹����ܼ��g�IJ����M�����M��LLM�ڔ��W�����̵��I���ѽ�չ�F����Խ������������������ѭ�}�sָ����Դ��ڲ��㡣���˽�Q�@һ���}��360���X�F���������A�[-�ԙzʽ��������Ϣ�ؿ��Ơ����ĵ�Light-IF��ܡ�

Light-IF���ͨ�^�傀�P�I�h��������ģ������:�y�ȸ�ָ֪�����ɡ�Zero-RL�����W��������ģʽ��ȡ�c�^�V���ر��ֱO���䆙�ӡ������m�����t�����W�����@һ��ܵ������ּ���ƽ⮔ǰ����ģ���д��ڵġ��ж��������F��ģ����˼���A�H�}��ָ��������әz��s���ǷM�㣬����ָ����в��_�Ć��}��

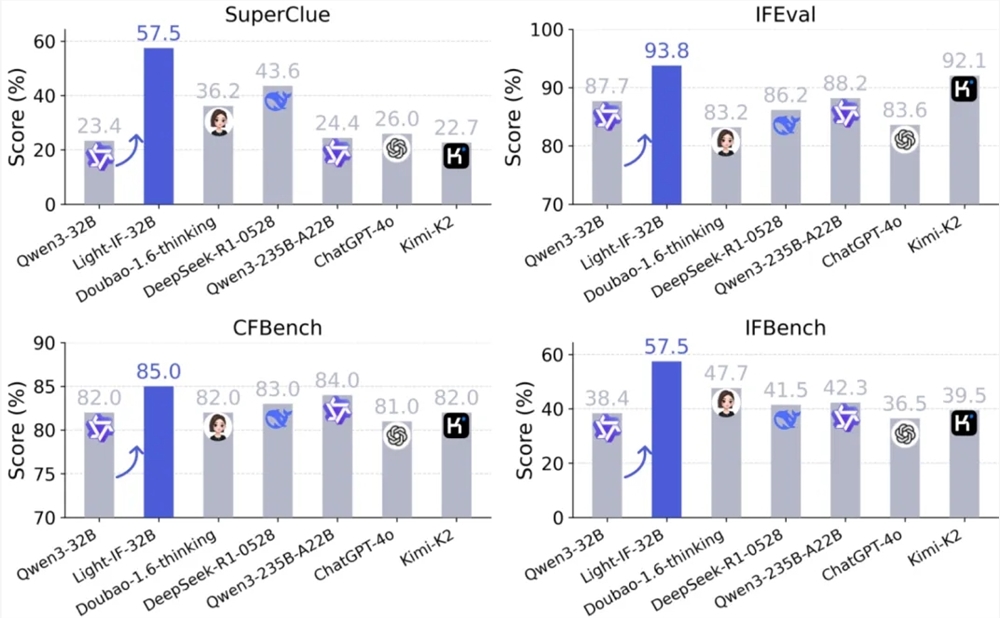

�ڌ���У�Light-IFϵ��ģ����SuperCLUE��IFEval��CFBench��IFBench�Ă����ĺͿ��Z��ָ����ѭ���Ͼ�ȡ�����@���������e��32B�汾��Light-IF-32B������SuperClue�÷��_����0.575������һ�����ģ�߳�13.9���ٷ��c�����⣬����Ҏģ�H��1.7B��Light-IF-1.7B��SuperClue��IFEval�ϵı��F�������^��Qwen3-235B-A22B���w�������ģ�͡�

360�����Ŷӱ�ʾ��Light-IFϵ��ģ�͵��Ƴ�������Ϊ��Դ�����ṩ��һ�ɸ��ֵ�����·�ߺ����Ŀ�Դ���룬����ȫϵģ�ͽ�½����Hugging Face�Ͽ��ţ�������ʹ�á��Ա��븴�֡�ͬʱ��ѵ����ʹ�õ����������ݼ�Ҳ��ͬ����GitHub�Ͽ��š����⣬360��SuperCLUE�����Ƴ������ľ�ȷָ����ѭ������SuperCLUE-CPIFOpenҲ����Github�Ͽ��ţ������о�������ģ�͵����ľ�ȷָ����ѭ������

�@һ��ģ�͵��Ƴ�����־��360���X�������˹�����ģ���}�sָ����ѭ���������~������Ҫһ�������˹����ܼ��g�İlչ�͑����_�����µĿ����ԡ�